Por el Dr. Fabian Vitolo

Introducción

La inteligencia artificial (IA) avanza aceleradamente en el sector salud: hoy se aplica al diagnóstico por imágenes (oftalmología, dermatología, gastroenterología, anatomía patológica y radiología), al análisis de señales y

datos moleculares, al desarrollo de fármacos y vacunas, a la predicción de complicaciones y pronóstico, a la clasificación de enfermedades y a la cirugía robótica. Además, su uso se expande de forma transversal en múltiples ámbitos clínicos, con creciente producción científica en los últimos años.

Entre sus oportunidades se destacan la mejora de la precisión diagnóstica y de la medicina personalizada, el apoyo a la decisión clínica como “segundo lector”, la priorización/triage más oportuno, la reducción de cargas de trabajo y

tiempos, y potenciales ganancias de eficiencia y costos. En entornos asistenciales reales, los modelos de IA se integran crecientemente como tecnologías de apoyo con human-in-the-loop, reforzando la seguridad del paciente sin desplazar el rol del profesional.

Ante este nuevo panorama, uno de los desafíos centrales para médicos, instituciones y aseguradoras es jurídico: ¿quién es responsable cuando una herramienta de IA contribuye a un daño al paciente? La literatura señala que la jurisprudencia específica aún es escasa y que la naturaleza opaca e intangible del software plantea dificultades para encuadrar la responsabilidad con doctrinas tradicionales de productos; al mismo tiempo, emerge la tesis de que no adoptar herramientas tecnológicas seguras podría, en ciertos contextos, convertirse también en una decisión riesgosa.

Este artículo busca revisar, con mirada práctica para Argentina, las implicancias de la IA en la responsabilidad profesional médica, analizando tendencias y marcos analíticos internacionales (p. ej., escenarios típicos de litigios y enfoques de gestión del riesgo), con énfasis en usos de IA integrada en la práctica clínica (human-in-the-loop) y en sus efectos sobre el estándar de cuidado, el consentimiento informado y el nexo causal.

Usos actuales y potenciales de la IA en medicina

La inteligencia artificial se ha introducido de manera creciente en múltiples áreas clínicas. En el ámbito diagnóstico, ya se aplica a la interpretación de imágenes médicas en oftalmología, dermatología, gastroenterología, anatomía

patológica y radiología, donde los algoritmos son capaces de identificar patrones complejos y asistir al médico en la detección precoz de patologías. En cardiología, por ejemplo, los algoritmos basados en electrocardiogramas han

mostrado superioridad frente al software tradicional para identificar ritmos y alteraciones, e incluso se proponen como herramientas de tamizaje en enfermedades valvulares.

En oncología y enfermedades crónicas, la IA ha demostrado ser útil en la predicción de la evolución, la respuesta terapéutica y la estratificación de riesgos, contribuyendo a una medicina más personalizada. También se ha

extendido a la cirugía robótica, a la predicción de complicaciones hospitalarias (ej. sepsis) y a la clasificación más precisa de enfermedades.

Otro uso relevante es el apoyo a la decisión clínica. Diversos autores destacan que los sistemas de IA funcionan mejor como “segundo lector”, complementando la interpretación del médico y aumentando la seguridad del

paciente. Este modelo de integración, conocido como human-in-the-loop, supone que el profesional mantiene el control y valida la recomendación algorítmica antes de tomar decisiones finales.

Asimismo, la IA contribuye a la eficiencia en la práctica clínica: permite priorizar estudios urgentes, optimizar la lista de lectura en radiología, filtrar casos menos complejos y reducir la carga de trabajo de los profesionales, mejorando la oportunidad diagnóstica y la asignación de recursos.

En síntesis, la IA se perfila no como un sustituto, sino como un amplificador de la capacidad médica, con potencial para transformar el diagnóstico, el pronóstico, la terapia y la organización de los sistemas de salud.

Nuevos desafíos éticos y legales

La expansión de la inteligencia artificial en salud no solo abre oportunidades, sino que plantea dilemas éticos y legales de enorme alcance. Estamos atravesando un cambio de paradigma: de la medicina basada en la evidencia, que se apoya en hipótesis formuladas y probadas de manera transparente, hacia una medicina basada en datos, donde los algoritmos generan predicciones útiles, pero a través de procesos internos difíciles de rastrear. Este fenómeno, conocido como la “caja negra”, implica que el médico puede recibir un resultado diagnóstico o pronóstico altamente preciso sin poder explicar con claridad qué razonamiento condujo a esa conclusión. La opacidad tiene implicancias críticas: debilita la autonomía del paciente, porque limita su capacidad de comprender los fundamentos de la decisión clínica, y socava la validez del consentimiento informado, que solo es pleno cuando se explican de forma comprensible los beneficios, riesgos y limitaciones de la herramienta tecnológica utilizada.

Otro desafío relevante es el de los sesgos algorítmicos. Los sistemas entrenados con poblaciones no representativas corren el riesgo de amplificar desigualdades preexistentes, generando disparidades en la calidad del diagnóstico y tratamiento entre distintos grupos poblacionales. Así, una tecnología que pretende mejorar la equidad en salud puede terminar acentuando inequidades si no se controla rigurosamente la calidad y diversidad de los datos utilizados.

La relación médica–paciente también se ve interpelada. El modelo fiduciario basado en la confianza y la empatía podría debilitarse si las decisiones clínicas dependen excesivamente de algoritmos. Algunos autores advierten que la introducción de IA puede reducir la escucha clínica, la exploración física y el “toque humano”, componentes esenciales del vínculo terapéutico. Esto plantea riesgos no solo en términos de calidad asistencial, sino también de percepción social y confianza en la medicina.

A nivel legal, se suma la dificultad de atribuir responsabilidades. Si un error ocurre, ¿es atribuible al médico que confió en la recomendación, al hospital que adoptó la herramienta, o al desarrollador del software? La doctrina tradicional de responsabilidad por productos defectuosos se ajusta mal a programas intangibles y opacos, lo que genera un vacío normativo.

En conjunto, estos desafíos muestran que la IA no es solo una innovación técnica: redefine categorías éticas y jurídicas centrales en medicina, y obliga a repensar marcos de consentimiento, equidad, relación médica–paciente y

atribución de responsabilidad.

Responsabilidad profesional médica

El marco tradicional de la responsabilidad médica se sustenta en cuatro elementos centrales: la existencia de un acto ilícito, entendido como la actuación de la profesional contraria a la lex artis; la producción de un daño al paciente; la comprobación de la culpa del profesional o, en su caso, de la violación del deber de seguridad por parte de la institución (factor de atribución); y la demostración del nexo causal entre la conducta y el perjuicio.

En términos jurídicos, un médico será considerado responsable cuando su proceder se aparte del estándar de cuidado, es decir, de lo que cabría esperar de un profesional competente en circunstancias semejantes y con recursos equivalentes.

La incorporación de la inteligencia artificial tensiona este marco. Por un lado, el error médico puede consistir en confiar ciegamente en la recomendación del algoritmo sin ejercer juicio crítico. Por otro, el error tecnológico puede originarse en defectos de diseño, entrenamiento con datos sesgados o falta de actualización del software. En muchos casos, lo más probable es que se trate de errores compartidos, donde la decisión clínica surge de la interacción entre médico y herramienta digital, difuminando la línea de atribución de responsabilidad.

Este escenario plantea desafíos inéditos para determinar qué constituye el estándar de cuidado. ¿Debe juzgarse al médico por no seguir la recomendación de la IA, o por haberla seguido sin cuestionarla? En algunos marcos

doctrinarios, se sugiere que no utilizar herramientas de IA validadas y disponibles podría ser visto en el futuro como una omisión negligente, del mismo modo que hoy lo sería no usar una guía clínica o una prueba diagnóstica

estandarizada. Sin embargo, también se advierte que el uso acrítico de algoritmos opacos puede constituir una violación del deber de prudencia, especialmente cuando el resultado es lesivo para el paciente.

En este contexto, la documentación clínica cobra un papel central: dejar asentado cuándo y cómo se usó la IA, cuál fue la interpretación profesional y cuáles fueron los factores que guiaron la decisión final. Esta práctica no solo

resguarda la trazabilidad clínica, sino que también fortalece la defensa en un eventual proceso legal, mostrando que el médico mantuvo un rol activo y no delegó completamente la decisión en la máquina.5

Jurisprudencia

La jurisprudencia específica sobre inteligencia artificial en salud todavía es escasa, pero existen antecedentes valiosos en litigios vinculados a software médico. Una investigación reciente —realizada por Michelle M. Mello, profesora de Derecho en Stanford Law School y de Políticas de Salud en la Stanford School of Medicine, junto con Neel Guha, estudiante de JD/PhD en Ciencias de la Computación en la misma universidad— analizó más de 800 casos judiciales y permitió identificar tres escenarios típicos de responsabilidad en los que puede derivar el uso de IA en medicina.

Aunque la mayoría de estos casos provienen de Estados Unidos, resultan ilustrativos para los debates que recién comienzan a abrirse en Argentina y América Latina, donde la adopción de IA en salud avanza sin que todavía exista una jurisprudencia consolidada ni marcos regulatorios específicos. Estos antecedentes internacionales ofrecen, entonces, un marco útil para anticipar riesgos y orientar la discusión local sobre responsabilidad profesional.

- Fallas en el software de gestión o de dispositivos médicos

Este primer grupo de casos se refiere a defectos en sistemas diseñados para organizar, administrar o monitorear funciones asistenciales, cuyo mal funcionamiento deriva en un daño al paciente. En Lowe v. Cerner, el tribunal aceptó la demanda de los pacientes al comprobar que un software de gestión de medicamentos tenía una interfaz defectuosa que llevó a los médicos a creer, de manera errónea, que habían programado la administración de un fármaco cuando en realidad no lo habían hecho. Algo similar ocurrió en Ambrose v. St. Joseph’s Hospital of Atlanta, donde se cuestionó a un hospital por no haber actualizado el software de un microscopio quirúrgico, lo que ocasionó perjuicios a los pacientes. Dado que se trataba de funciones de carácter administrativo, la

acción legal fue encuadrada como negligencia corporativa y no como un reclamo de mala praxis médica.

2. Daños por decisiones clínicas basadas en IA

El segundo escenario se presenta cuando el daño ocurre porque los médicos consultan sistemas de IA para tomar decisiones clínicas y siguen sus recomendaciones erróneas. En Sampson v. HeartWise Health Systems

Corporation (2023), un programa de cribado cardíaco clasificó como “normal” a un joven adulto con antecedentes familiares de cardiopatías congénitas. Los médicos confiaron en ese resultado y semanas más tarde el paciente falleció. En este tipo de casos, la responsabilidad de los profesionales suele evaluarse según lo que otros especialistas hubieran hecho en circunstancias semejantes.

En Sampson, el tribunal permitió que la causa avanzara al considerar que los médicos debieron haber cuestionado la recomendación del software o alcanzado por sí mismos el diagnóstico correcto.

Respecto de los desarrolladores, los fallos han sido dispares: en algunos tribunales se rechazaron reclamos por defectos de diseño bajo el argumento de que los algoritmos no son “productos” y que aplicarles la doctrina de

responsabilidad civil podría incluso afectar derechos constitucionales. En otros procesos, en cambio, se admitieron demandas por negligencia contra los fabricantes al entender que habían incumplido el estándar de cuidado. En el

propio caso Sampson, la demanda contra el desarrollador fue desestimada porque el contrato de licencia del software asignaba la decisión final a los médicos y la empresa no era considerada un prestador de salud según la legislación estatal.

3. Errores de diseño y actualización en software integrado a dispositivos

El tercer escenario involucra situaciones en las que el software embebido en dispositivos médicos presenta fallas que terminan dañando a los pacientes.

Estos reclamos suelen dirigirse tanto contra médicos e instituciones — acusados de un uso, instalación o mantenimiento negligente— como contra los desarrolladores responsables del diseño y la actualización del sistema. En Seargeant v. Orthopedic Associates Medical Clinic, por ejemplo, médicos, un técnico y una clínica fueron demandados tras un error humano durante la reprogramación de una bomba de infusión, que derivó en una dosis letal de morfina. En otros casos, los demandantes han intentado responsabilizar a los fabricantes por defectos de diseño, fabricación o advertencias insuficientes. Sin embargo, muchos de estos reclamos fracasan cuando los tribunales exigen la identificación de una falla de diseño específica y los demandantes se limitan a señalar el fallo del software como prueba del defecto. Se refiere a fallas en el software embebido dentro de dispositivos médicos, como robots quirúrgicos, bombas de infusión o sistemas de monitoreo.

La revisión de estos casos muestra tres lecciones clave:

- Los demandantes enfrentan dificultades para sostener sus reclamos si no pueden identificar fallas de diseño específicas en el software. No basta con demostrar que se produjo un error: es necesario explicar cómo y por qué ocurrió.

- Los algoritmos de IA no rinden igual en todas las poblaciones de pacientes, lo que complica probar que un médico debía prever que el resultado no era confiable en un caso particular.

- Los tribunales tienden a no distinguir entre IA y software tradicional, lo que genera el riesgo de que decisiones tomadas sobre un tipo de sistema se apliquen automáticamente a otros, aun cuando deberían tratarse de forma diferenciada.

La revisión de estos escenarios muestra que la responsabilidad vinculada a la inteligencia artificial en salud no es una cuestión hipotética, sino un desafío real y en expansión. Para la práctica clínica, la principal enseñanza es que la IA debe ser entendida como una herramienta de apoyo y no como sustituto del juicio profesional: documentar cómo se utilizó, ejercer un control crítico sobre sus resultados y mantener la autonomía en la decisión médica son condiciones indispensables para reducir riesgos. Para el ámbito legal, la lección es que los marcos normativos tradicionales resultan insuficientes para abordar tecnologías intangibles y opacas, lo que exige repensar el estándar de cuidado, clarificar la responsabilidad de desarrolladores e instituciones y anticipar que la omisión en el uso de IA segura podría, en el futuro, ser considerada una forma de negligencia. En definitiva, tanto médicos como hospitales y aseguradoras deben prepararse para un escenario donde la responsabilidad será más compartida, compleja y dinámica, y donde la trazabilidad, la transparencia y la actualización continua serán claves para proteger tanto a los pacientes como a los profesionales.

Marco regulatorio y propuestas internacionales

El debate sobre la responsabilidad vinculada a la inteligencia artificial en salud no puede separarse de la discusión regulatoria. Aunque la jurisprudencia es aún incipiente, distintas regiones han comenzado a delinear marcos normativos que buscan equilibrar innovación con seguridad del paciente.

En Estados Unidos, la Administración de Alimentos y Medicamentos (FDA) ha establecido un marco preliminar para la aprobación de algoritmos médicos, con énfasis en los denominados Software as a Medical Device (SaMD). Sin embargo, la normativa se centra en la autorización previa y no en la asignación de responsabilidades, lo que deja un vacío frente a reclamos por daños. Además, la doctrina del “preemption” impide que los pacientes demanden en tribunales estatales por ciertos dispositivos aprobados a nivel federal por la FDA, lo que restringe la vía judicial.

En la Unión Europea, el Parlamento aprobó en 2023 la AI Act, la primera ley integral sobre inteligencia artificial. Esta normativa clasifica las aplicaciones de IA en niveles de riesgo y establece obligaciones más estrictas para aquellas consideradas de alto impacto, como las destinadas a diagnóstico o tratamiento médico. La lógica de “riesgo proporcional” implica que los desarrolladores deben demostrar transparencia, trazabilidad y supervisión humana en el ciclo de vida del producto. Aunque aún resta definir cómo se aplicará en los distintos Estados miembros, este enfoque podría convertirse en estándar global.

En América Latina, los marcos regulatorios son fragmentarios. Países como Brasil y Chile han iniciado debates legislativos sobre inteligencia artificial, pero en el terreno sanitario no existen aún normas específicas. En Argentina, la IA se encuentra regulada de manera indirecta a través de la normativa de la ANMAT sobre software de dispositivos médicos, pero no hay disposiciones claras respecto de la responsabilidad civil o penal en casos de fallas. Esta ausencia normativa refuerza la importancia de recurrir a marcos comparados y a la doctrina local sobre responsabilidad médica y hospitalaria.

Una cuestión central en la literatura es el rol de los contratos privados. Los acuerdos de licencia entre hospitales y desarrolladores de IA pueden asignar explícitamente la responsabilidad final al médico, como ocurrió en el caso Sampson v. HeartWise Health Systems Corporation, donde se desestimó la demanda contra el desarrollador porque el contrato establecía que la decisión última recaía en los profesionales. Esta tendencia muestra que la distribución de riesgos puede depender más de negociaciones contractuales que de normas generales, generando desigualdad entre instituciones con mayor o menor capacidad de negociación.

En conjunto, la comparación internacional revela un panorama desigual: mientras la UE avanza con un marco legislativo robusto y preventivo, Estados Unidos mantiene un enfoque fragmentado, y América Latina —incluida

Argentina— se encuentra aún en una etapa incipiente. Para el sistema sanitario argentino, el desafío será doble: adoptar criterios de transparencia, auditoría y supervisión humana, inspirados en marcos internacionales, y al mismo tiempo adaptar estos principios a la doctrina nacional de responsabilidad profesional.

En un contexto local, puede pensarse cómo operaría un mecanismo similar si existiera en Argentina bajo la órbita de la ANMAT. Supongamos que un hospital adopta un software de IA para análisis radiológico aprobado como “software de dispositivo médico”. Si ese sistema falla —por ejemplo, detecta un nódulo, pero omite otras lesiones críticas que el médico tampoco advierte— y el paciente decide demandar, la existencia de una regla similar a la de preemption en los EE.UU significaría que no podría accionar contra el desarrollador del software, ya que su producto había sido previamente evaluado y autorizado por la autoridad nacional. En consecuencia, la responsabilidad recaería casi exclusivamente en el médico, por no haber ejercido juicio crítico, o en la institución, por no implementar mecanismos de doble verificación. Este escenario muestra cómo la lógica de la preemption puede terminar debilitando la exigencia de responsabilidad y mejoras a los fabricantes y limitando la capacidad de los pacientes para reclamar frente a fallas de origen tecnológico.

Implicancias para la práctica clínica y el seguro de responsabilidad profesional

La incorporación de la inteligencia artificial al ejercicio médico no elimina las reglas tradicionales de la responsabilidad, pero sí introduce matices que obligan a replantear prácticas, protocolos y coberturas. Para las aseguradoras de responsabilidad médica, estos cambios representan tanto un desafío como una oportunidad para acompañar a profesionales e instituciones en la transición hacia un nuevo escenario de riesgos.

Para el médico, el uso de IA debe entenderse como un apoyo y no como un sustituto del juicio clínico. La principal implicancia es la necesidad de documentar explícitamente cuándo y cómo se utilizó la herramienta, cuál fue la

interpretación del profesional y qué factores guiaron la decisión final. Este registro es clave para mostrar que el médico mantuvo un rol activo y no delegó completamente en el algoritmo. Además, en un eventual juicio, la trazabilidad de este razonamiento constituye un elemento central de defensa.

Los hospitales y clínicas se enfrentan a su vez a la necesidad de establecer políticas claras de adopción de IA: desde la selección y validación de las herramientas hasta la capacitación de los equipos y la auditoría periódica de su

desempeño. La literatura muestra que muchas demandas surgen no solo de fallas tecnológicas, sino también de la falta de actualización o mantenimiento de los sistemas. Por eso, la gobernanza institucional en torno a la IA se convierte en un requisito esencial para reducir riesgos legales y proteger la seguridad del paciente.

Para las aseguradoras, la expansión de la IA en salud plantea el desafío de ajustar las pólizas de responsabilidad profesional. En la práctica, será necesario repensar exclusiones, condiciones y coberturas, considerando escenarios donde el daño provenga de un algoritmo defectuoso o de un contrato de licencia que asigna la responsabilidad al médico o a la institución. Las aseguradoras deberán anticipar que el riesgo será compartido entre médicos, instituciones y desarrolladores, y que los reclamos podrían involucrar nuevas formas de corresponsabilidad.

Ya vimos en la revisión de casos que la responsabilidad por fallas de IA es difusa y compartida. En algunos escenarios, los tribunales responsabilizan al médico por seguir sin cuestionar la recomendación del software; en otros, al hospital por no actualizarlo; y en otros, al desarrollador por defectos de diseño.

Esto refuerza la importancia de diseñar pólizas que contemplen esta interdependencia de actores, incorporando coberturas integradas que protejan al profesional, a la institución y —en la medida en que evolucione la regulación— también a los proveedores tecnológicos.

En síntesis, la práctica clínica y la gestión aseguradora deben adaptarse a un nuevo escenario en el que la inteligencia artificial redefine el estándar de cuidado, multiplica los puntos de riesgo y obliga a pensar en coberturas integrales. La clave será acompañar a los asegurados en la implementación de buenas prácticas —documentación, trazabilidad, auditorías— y en el desarrollo de productos aseguradores que reflejen la realidad compleja de la medicina del futuro inmediato.

Estrategias de mitigación y gestión de riesgos

La incorporación de inteligencia artificial en la práctica médica exige no solo innovación tecnológica, sino también estrategias proactivas de gestión de riesgos. Para profesionales, instituciones y aseguradoras, anticipar escenarios críticos y establecer defensas en profundidad resulta fundamental para garantizar la seguridad del paciente y reducir la exposición a reclamos.

- Protocolos y trazabilidad clínica El primer paso es establecer protocolos claros sobre cuándo y cómo utilizar

herramientas de IA. En la historia clínica debería quedar asentado no solo el uso del sistema, sino también la interpretación del médico y la decisión final. Una anotación podría decir: “Se utilizó software de IA para análisis de imagen de tórax. El sistema sugirió nódulo en base pulmonar derecha. Se revisa y confirma hallazgo en tomografía. Decisión: control en 3 meses”. De esta manera, se demuestra que el profesional ejerció un juicio crítico y mantuvo un rol activo.

- Consentimiento informado específico Dada la opacidad de los algoritmos (“caja negra”), es fundamental que el

consentimiento informado incluya una referencia sencilla al uso de IA como apoyo diagnóstico o terapéutico. En la práctica clínica, esto podría registrarse así: “Paciente informado de que para la interpretación de imágenes se utilizará un software de IA como apoyo diagnóstico. Se explicó que la decisión final corresponde al médico tratante. Paciente comprende y acepta”. Este registro protege la autonomía del paciente y asegura que el consentimiento sea válido.

- Auditorías y control de calidad Las instituciones deben implementar auditorías periódicas sobre el desempeño

de los sistemas de IA. Incluso esos controles pueden reflejarse en los registros clínicos o institucionales. Por ejemplo: “Auditoría interna 06/2025: revisión de 50 informes de IA en radiología. Precisión global: 92 %. Se detecta sesgo en la detección de lesiones en mujeres jóvenes. Se notifica al comité de calidad y se solicita actualización de algoritmo al proveedor”. Dejar constancia de este tipo de procesos evidencia monitoreo activo y compromiso con la seguridad.

- Capacitación continua La formación de médicos y técnicos en el uso de IA es indispensable, La misma

debe quedar registrada en un legajo interno institucional, donde consten las instancias de capacitación y las actas de asistencia de cada profesional. Así, por ejemplo, el registro podría señalar: “Dr. XX participó en el curso de capacitación institucional sobre software IA radiológico (dictado en 05/2025), con constancia de asistencia y aprobación de contenidos básicos de uso seguro”. Este tipo de documentación interna permite demostrar que el profesional contaba con entrenamiento adecuado y supervisión, reforzando la defensa frente a reclamos legales.

- Contratos con proveedores tecnológicos Un aspecto crítico de la gestión de riesgos es la manera en que se negocian y redactan los contratos con los proveedores de sistemas de inteligencia artificial.

Muchas licencias estándar trasladan la responsabilidad final al médico o a la institución, liberando de obligaciones al desarrollador. Por eso, las organizaciones de salud deben avanzar hacia contratos más equilibrados, que contemplen:

Garantías de calidad y seguridad, con obligación del proveedor de asegurar que el software cumple con normas regulatorias nacionales (por ejemplo, ANMAT en Argentina) e internacionales.

- Planes de actualización y mantenimiento, que definan tiempos y responsabilidades en la instalación de nuevas versiones, parches de seguridad y mejoras de rendimiento.

- Soporte técnico accesible y documentado, que incluya protocolos claros de atención a incidentes críticos y plazos máximos de respuesta.

- Responsabilidad compartida en caso de fallas, evitando cláusulas que asignen automáticamente toda la carga legal al hospital o al profesional. Esto implica, por ejemplo, que el proveedor se haga cargo cuando el

daño se deba a defectos de diseño o a falta de actualización del algoritmo. - Transparencia y auditabilidad, con acceso a información suficiente sobre cómo funciona el sistema, tasas de error, sesgos identificados y limitaciones conocidas.

- Cobertura aseguradora del proveedor, que asegure respaldo económico en caso de que un daño atribuible a la tecnología dé lugar a un reclamo judicial.

En definitiva, los contratos no deben limitarse a la provisión del software, sino que deben concebirse como una herramienta de gestión de riesgos, que distribuya de manera justa las responsabilidades entre el desarrollador, la institución y el equipo clínico. La combinación de protocolos, consentimiento informado específico, auditorías, capacitación, cláusulas contractuales claras y el rol activo de las aseguradoras conforma un marco de mitigación de riesgos que permite integrar la IA a la práctica clínica de manera segura y jurídicamente sólida.

Pensando a futuro

La inteligencia artificial no reemplaza al médico, pero sí redefine profundamente su rol. El juicio clínico, la capacidad crítica y la documentación rigurosa se vuelven más importantes que nunca para mostrar que las decisiones se toman en forma informada y responsable. La responsabilidad profesional se convierte en un fenómeno compartido, dinámico y más complejo, que involucra a médicos, instituciones, desarrolladores y aseguradoras.

Como advierten Mello y Guha, el futuro de la doctrina de responsabilidad civil aplicada a la IA en salud es altamente incierto. Existe aún un cuerpo limitado de jurisprudencia y, en muchos casos, los tribunales no diferencian entre software médico tradicional e inteligencia artificial, cuando esas distinciones son cruciales para determinar responsabilidad. Mientras se aguarda mayor claridad normativa, el foco debe ponerse en cómo los profesionales y las organizaciones de salud gestionan de manera preventiva los riesgos. El marco propuesto por estos autores para evaluar el riesgo de responsabilidad de la IA en el ámbito sanitario se basa en literatura previa y conceptualiza el riesgo como una función de cuatro factores principales que deberían guiar las decisiones de adopción y la supervisión de seguridad posterior a la implementación en función de estos indicadores de riesgo:

- La probabilidad y la naturaleza de los errores (según el modelo de IA, sus datos de entrenamiento, el diseño de la tarea y la manera en que se integra en el flujo de trabajo clínico).

- La probabilidad de que los humanos u otro sistema detecten los errores antes de que causen daño a los pacientes (lo cual depende, en parte, del tiempo y del nivel de visibilidad que los humanos tengan sobre la herramienta de IA).

- El daño potencial si los errores no son detectados (especialmente en el caso de herramientas que realizan funciones clínicas críticas o que se utilizan en la atención de pacientes con condiciones de salud graves).

- La probabilidad de que las lesiones reciban compensación en el sistema de responsabilidad civil, lo que depende, entre otras cosas, de la gravedad de la lesión, la facilidad para probar negligencia y la relación causal entre la herramienta de IA y el daño.

También es importante reconocer que las organizaciones de salud se encuentran en un mercado favorable para los compradores, en el que muchos desarrolladores de IA compiten por asegurar contratos con los sistemas de

salud y por acceder a los datos de los pacientes. Este mercado otorga a los compradores del sector sanitario la oportunidad de negociar condiciones que minimicen el riesgo de responsabilidad. Por ejemplo, los acuerdos de licencia deberían exigir a los desarrolladores que proporcionen información que permita a las organizaciones de salud evaluar y monitorear eficazmente el riesgo, incluyendo datos sobre las suposiciones en relación con la información utilizada para entrenar el modelo, los procesos de validación y las recomendaciones para auditar el desempeño del modelo.

Las cláusulas de indemnización representan un recurso clave para asignar responsabilidades en caso de fallas. A través de ellas, las instituciones de salud pueden definir de manera anticipada quién asume los costos frente a un error. Así, por ejemplo, se puede estipular que los desarrolladores respondan cuando el fallo provenga de una deficiencia en el algoritmo, mientras que los hospitales lo hagan si el problema deriva de una implementación incorrecta o de un uso indebido de la herramienta de IA. Además, los contratos entre organizaciones sanitarias y proveedores tecnológicos deberían incluir condiciones mínimas de cobertura aseguradora y establecer con claridad el deber de las instituciones de realizar un seguimiento y monitoreo continuo de los sistemas una vez incorporados a la práctica clínica.

Los formuladores de políticas pueden desempeñar un papel decisivo en la prevención de daños asociados a la inteligencia artificial en salud. Una vía posible es establecer normativas que obliguen a los desarrolladores a brindar

información clara sobre cómo se entrenan y configuran los modelos, de modo que hospitales y profesionales cuenten con los elementos necesarios para utilizarlos de forma segura. También sería recomendable definir lineamientos que indiquen cómo informar a los pacientes cuando la IA interviene en decisiones diagnósticas o terapéuticas, fortaleciendo así la base del consentimiento informado. A su vez, el ámbito legal deberá adaptarse: los abogados tendrán que desarrollar una mayor comprensión sobre IA aplicada a la salud para poder litigar con eficacia en este terreno emergente.

Para la realidad argentina, estas conclusiones son especialmente pertinentes. La ausencia de jurisprudencia y regulación específica obliga a médicos e instituciones a adoptar estándares de gobernanza inspirados en experiencias internacionales y, al mismo tiempo, a trabajar con aseguradoras para adaptar pólizas y coberturas. Estas tienen un rol estratégico: acompañar a los asegurados en la implementación de protocolos de trazabilidad, promover auditorías periódicas, asesorar en la negociación de contratos con proveedores y diseñar coberturas que contemplen la interdependencia entre profesionales, instituciones y desarrolladores tecnológicos.

En definitiva, la seguridad del paciente y la confianza social en el uso de inteligencia artificial dependerán de cómo logremos equilibrar la innovación tecnológica con la responsabilidad ética y legal. Gestionar de manera

responsable la responsabilidad civil no solo permitirá aprovechar el potencial de la IA para mejorar la calidad de la atención, sino también construir un entorno de práctica más seguro y sostenible para médicos e instituciones.

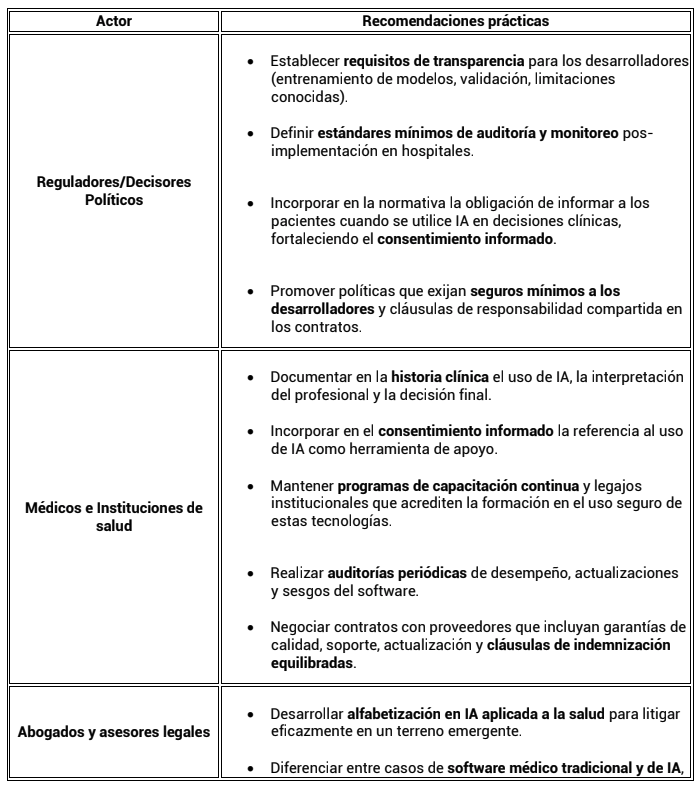

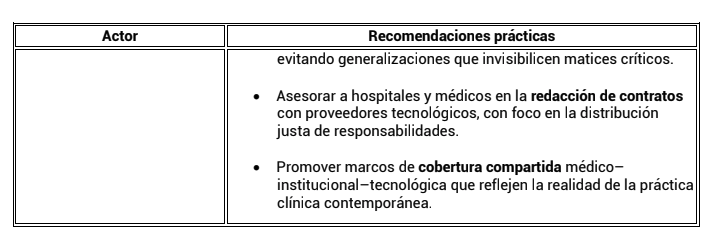

Resumen de recomendaciones Actor Recomendaciones prácticas

Bibliografía

Terranova C, Cestonaro C, Fava L, Cinquetti A. AI and professional liability

assessment in healthcare. A revolution in legal medicine? Front Med

(Lausanne). 2024 Jan 8;10:1337335.

Cestonaro C, Delicati A, Marcante B, Caenazzo L, Tozzo P. Defining medical

liability when artificial intelligence is applied on diagnostic algorithms: a

systematic review. Front Med (Lausanne). 2023 Nov 27;10:1305756.

Mello MM, Guha N. Understanding Liability Risk from Using Health Care Artificial

Intelligence Tools. N Engl J Med. 2024 Jan 18;390(3):271-278.

MedTech Europe. Liability Challenges in AI medical technologies. August 2022.

Solaiman B, Cohen IG, editors. Research Handbook on Health, AI and the Law.

Cheltenham, UK: Edward Elgar Publishing Ltd; 2024 Jul 16.

https://www.ncbi.nlm.nih.gov/books/NBK613192/

Por el Dr. Fabian Vitolo